Autopsie dune valuation 1 QUELQUES PISTES POUR MIEUX

- Slides: 42

Autopsie d’une évaluation 1 QUELQUES PISTES POUR MIEUX COMPRENDRE L’ÉVALUATION CM 2 DE JANVIER 2009 Roland Charnay - SNUIPP octobre 2009

Mise en bouche… 2 La méthode doit être "incontestée et incontestable", ce qui n'a "pas été le cas". "Le contenu, le calendrier ou encore le système de notation ont fait l'objet de critiques parfois justifiées. Les évaluations seront d'autant mieux acceptées que la méthode ne pourra être contestée » (rapport d’un groupe de travail UMP) En CM 2, un taux élevé de réponses incomplètes, une faible qualité des données recueillies. Du coup les données indiquées sont accompagnées d'un taux d'erreur important et les objectifs sont revus. (Premiers documents budgétaires 2010) Roland Charnay - SNUIPP octobre 2009

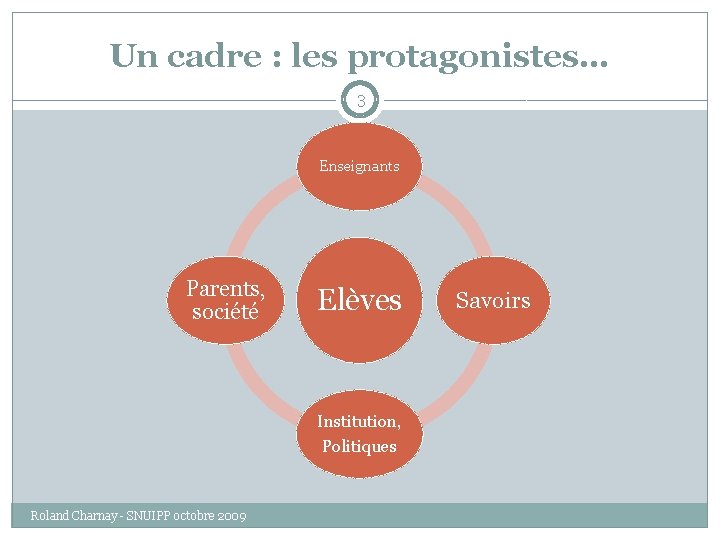

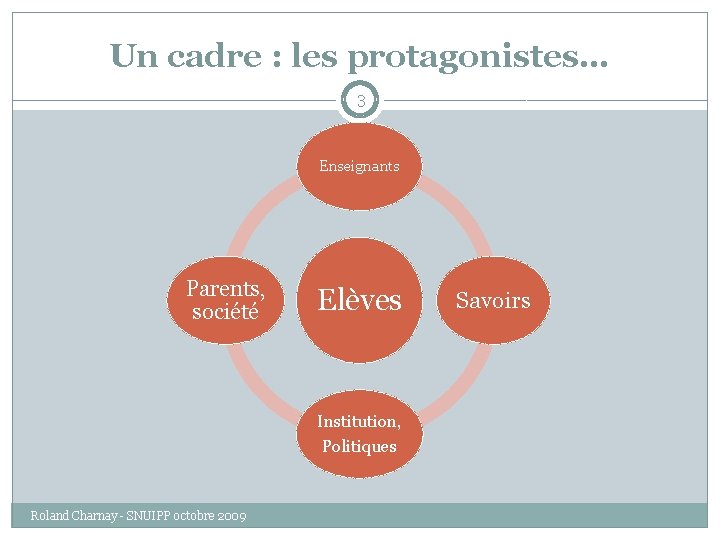

Un cadre : les protagonistes… 3 Enseignants Parents, société Elèves Institution, Politiques Roland Charnay - SNUIPP octobre 2009 Savoirs

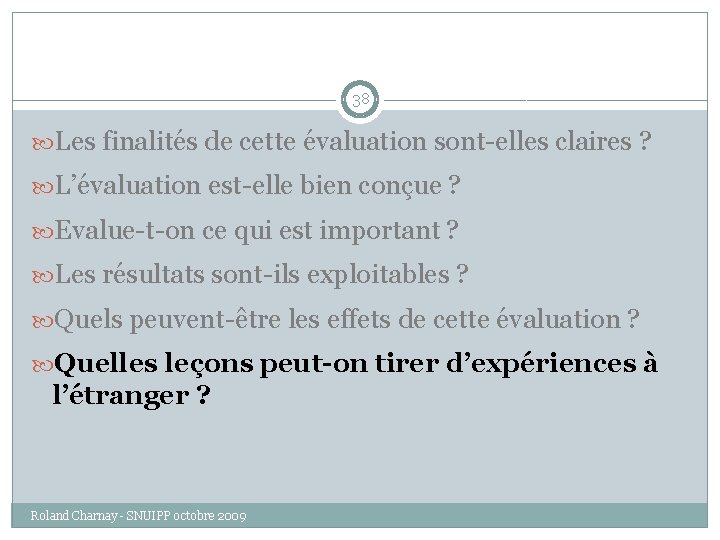

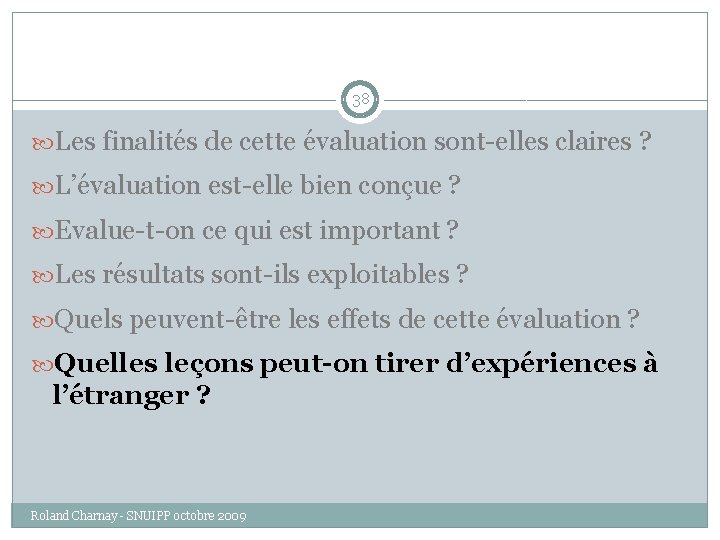

Des questions 4 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

5 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

Pourquoi de nouvelles évaluations ? Réponse du MEN (sur son site) 6 mesurer les acquis des élèves à deux moments clefs de leur scolarité élémentaire, renforcer les compétences des élèves là où elles sont insuffisantes en mobilisant les dispositifs d'aide personnalisée, informer les parents et leur permettre de suivre les progrès de leur enfant, disposer d'indicateurs fiables des acquis des élèves pour mieux piloter le système éducatif et favoriser l'égalité des chances de l'école au niveau national. Roland Charnay - SNUIPP octobre 2009

Analyse 7 Les cibles principales semblent être : L’institution (mesurer les acquis, piloter le système) Les parents Les enseignants ne sont pas nommes explicitement, sauf au travers de la référence à l’aide personnalisée (et non à travers leur enseignement en classe) Comme dans les évaluations précédentes, plusieurs cibles sont ainsi visées Mais à l’inverse des précédentes (CE 2 et 6 e), le pilotage institutionnel est prioritaire… Roland Charnay - SNUIPP octobre 2009

Ce que confirme cette phrase de JL Nembrini (Directeur général de l’enseignement scolaire) 8 Les nouvelles évaluations des élèves en français et en mathématiques, en CE 1 et en CM 2, sont un des éléments majeurs de la réforme du premier degré. D’une manière générale, l’évaluation des résultats des élèves est la clé de voûte du système que nous mettons en place. Selon « Le Robert » , clé de voûte signifie « point important, partie essentielle, capitale d’un système » L’évaluation serait donc là pour « soutenir » le programme 2008 ! Roland Charnay - SNUIPP octobre 2009

9 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

Qui évalue ? 10 Ces évaluations ont été mises au point par la Direction de l’enseignement scolaire qui avait produit les programmes… … alors qu’existe un service spécialisé pour ce type d’études (avec un savoir-faire et des spécialistes) : la DEPP, direction de l’évaluation, de la prospective et de la performance) Elle a d’ailleurs publié une étude qui pointe, en calcul, une baisse importante des scores obtenus entre 1987 et 1999 qui touche tous les niveaux de compétences et s’accompagne d’un accroissement de la dispersion des scores. Elle ajoute que : de 1999 à 2007, il s’opère un « tassement » des résultats et émet l’hypothèse que ce redressement est peut-être à mettre au compte de la remise à l’ordre du jour du calcul dans les programmes de 2002 avec, en particulier, l’accent mis sur le calcul mental et l’apprentissage des techniques opératoires. Roland Charnay - SNUIPP octobre 2009

Des questions 11 Pourquoi le MEN n’a-t-il pas confié à la DEPP la mise au point de cette évaluation ? Crainte de perdre le contrôle des compétences évaluées ? Peur de ne pas maîtriser la présentation des résultats et des analyses ? Quels acteurs sont impliqués dans l’élaboration, la passation et la correction de ces épreuves ? Pour l’élaboration, les auteurs ne sont pas connus Pour la passation, les conditions sont strictes, mais le risque de manque d’homogénéité est grand Pour la correction, les enseignants sur la base d’un codage imposé par le MEN Dans les 2 cas, déresponsabilisation des enseignants Roland Charnay - SNUIPP octobre 2009

Aspects éthiques et scientifiques 12 D’un point de vue scientifique, mais aussi éthique, il est anormal que ceux qui élaborent les programmes et qui arrêtent les orientations de la politique éducative prétendent en évaluer les résultats (…). Elles interviennent au moment où la nécessaire autonomie scientifique de cette instance (la DEPP) chargée de l’évaluation au sein du ministère semble être remise en cause (J-C Emin, interview au SE) Roland Charnay - SNUIPP octobre 2009

Aspects éthiques et scientifiques 13 La conception de ces épreuves standardisées est de plus en plus confiée à des autorités externes indépendantes des ministères qui assez logiquement ne peuvent pas être juges et parties quand ces tests servent à évaluer leur politique. L’externalisation de l’élaboration des tests est fondamentale pour trois raisons : elle permet de mobiliser une expertise accrue qu’il est difficile de trouver en vase-clos, elle est une des conditions de l’association au dispositif des acteurs concernés sur le terrain – les enseignants- et donc de leur acceptation sociale finale du programme, elle garantit transparence et donc une légitimité démocratique au système. C’est donc aujourd’hui le modèle largement dominant. L’évolution récente de la France (la dernière année) vers un dispositif qui privilégie les acteurs internes au ministère ne suit pas cette tendance de fond. Nathalie Mons, auteur du rapport « Les effets théoriques et réels de l’évaluation standardisée), dans un entretien avec le Café Pédagogique (18/09/09) Roland Charnay - SNUIPP octobre 2009

L’évaluation est-elle adaptée à ses objectifs généraux ? 14 Non, s’il s’agit de disposer d’indicateurs fiables pour « le système » Une évaluation sur échantillon suffit Une évaluation « externe » est indispensable, avec passation et correction par des personnes extérieures à la classe Le nombre d’exercices doit être beaucoup plus important, ce qui est possible avec des échantillons différents (cf. travail de la DEPP, note d’info n° 08 -37 : 244 items sous la forme de 13 blocs de 17 items, chaque élève étant soumis à 4 blocs) Roland Charnay - SNUIPP octobre 2009

L’évaluation est-elle adaptée à ses objectifs généraux ? 15 Non, s’il s’agit de connaître les acquis et difficultés de chaque élève, de repérer les progrès Évaluation proposée à tous en janvier, sans tenir compte des progressions de chaque enseignant (malgré le rappel de la « liberté pédagogique » ) ET donc évaluation ne distinguant pas ce qui a été travaillé ou retravaillé et ce qui ne l’a pas été Codage binaire ne permettant pas de repérer les réussites partielles, les procédures particulières, les types d’erreurs… Temps contraint qui ne laisse pas la possibilité à un élève de « réussir à son rythme » … En cours d’année, c’est l’enseignant qui est le mieux placé pour ce travail (avec l’aide possible de ressources : banques d’exercices, résultats permettant des comparaisons…) Roland Charnay - SNUIPP octobre 2009

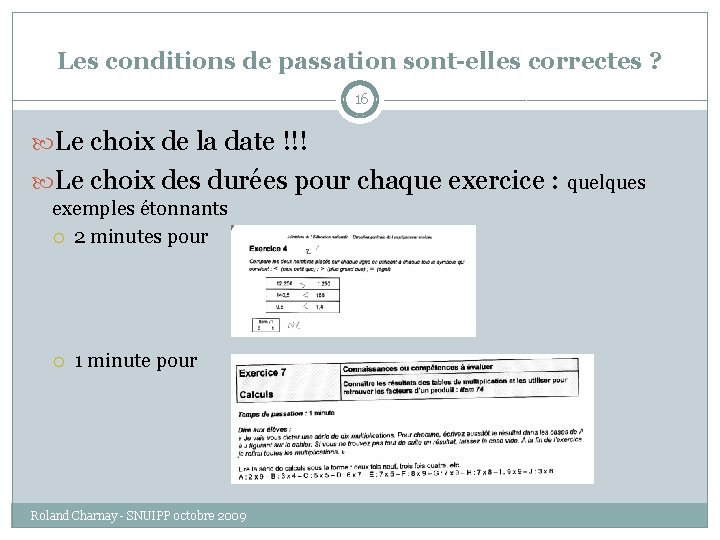

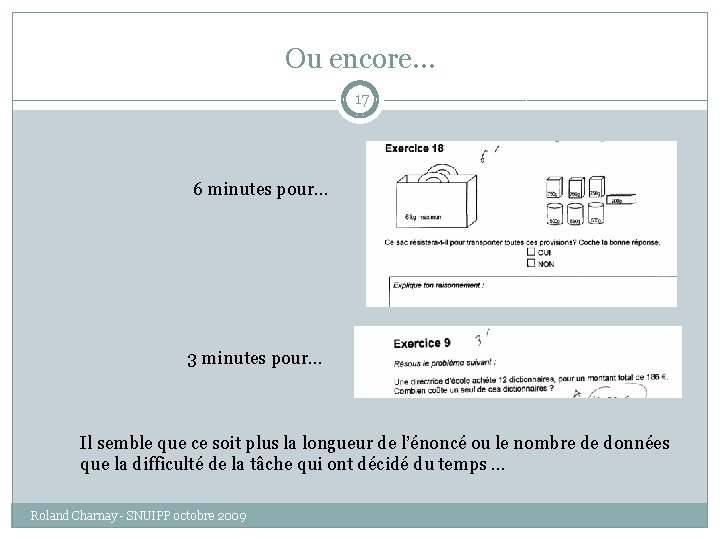

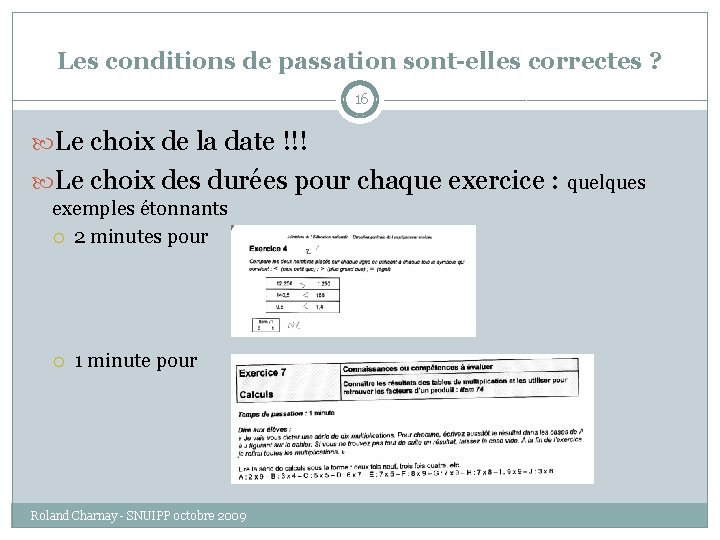

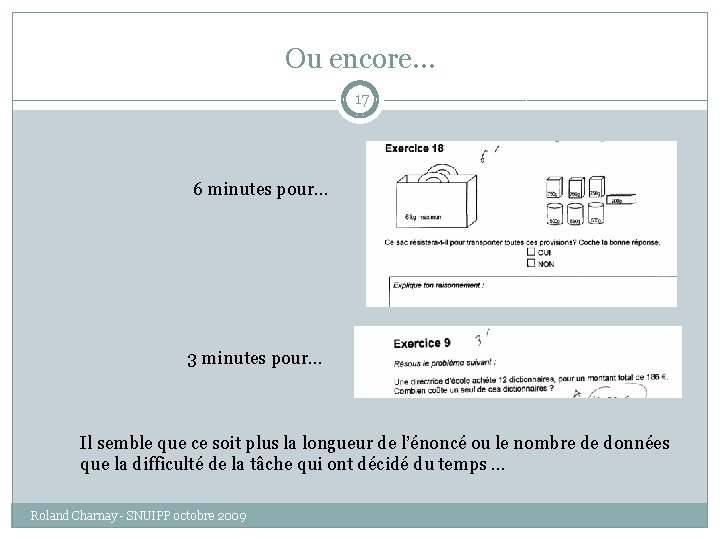

Les conditions de passation sont-elles correctes ? 16 Le choix de la date !!! Le choix des durées pour chaque exercice : quelques exemples étonnants 2 minutes pour 1 minute pour Roland Charnay - SNUIPP octobre 2009

Ou encore… 17 6 minutes pour… 3 minutes pour… Il semble que ce soit plus la longueur de l’énoncé ou le nombre de données que la difficulté de la tâche qui ont décidé du temps … Roland Charnay - SNUIPP octobre 2009

Les compétences annoncées sont-elles toujours les compétences évaluées ? 18 Point crucial car ce sont les compétences de l’élève qui sont observées car on va rendre public les résultats non par sur l’exercice, mais sur la compétence Car on va porter un jugement sur l’efficacité des enseignements Question particulièrement délicate lorsqu’il s’agit de la résolution de problème du fait de la formulation d’une compétence générale alors que de nombreuses compétences locales sont nécessaires Du fait que, plus encore qu’ailleurs, le choix des problèmes posés influe sur le résultat. Roland Charnay - SNUIPP octobre 2009

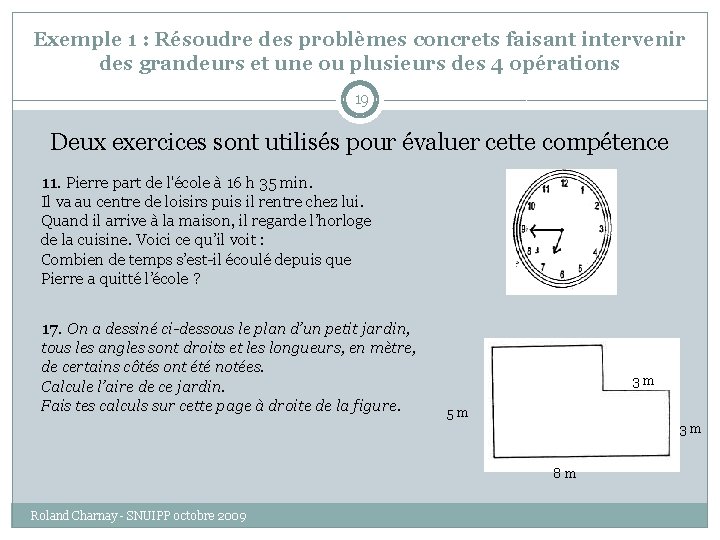

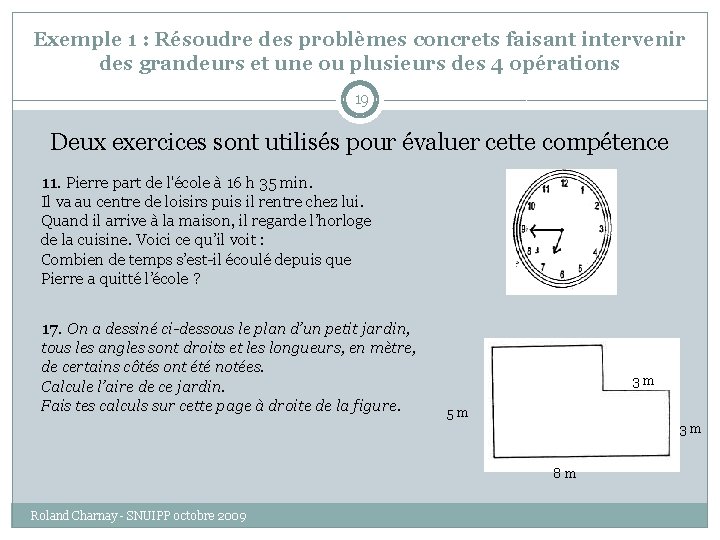

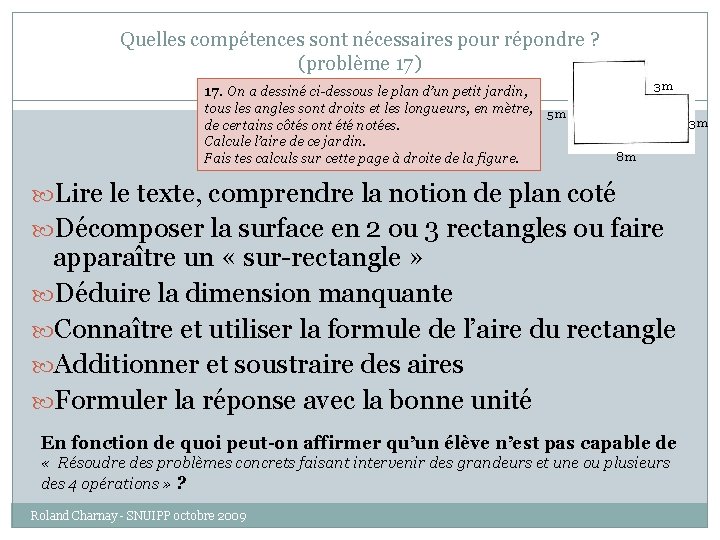

Exemple 1 : Résoudre des problèmes concrets faisant intervenir des grandeurs et une ou plusieurs des 4 opérations 19 Deux exercices sont utilisés pour évaluer cette compétence 11. Pierre part de l'école à 16 h 35 min. Il va au centre de loisirs puis il rentre chez lui. Quand il arrive à la maison, il regarde l’horloge de la cuisine. Voici ce qu’il voit : Combien de temps s’est-il écoulé depuis que Pierre a quitté l’école ? 17. On a dessiné ci-dessous le plan d’un petit jardin, tous les angles sont droits et les longueurs, en mètre, de certains côtés ont été notées. Calcule l’aire de ce jardin. Fais tes calculs sur cette page à droite de la figure. 3 m 5 m 3 m 8 m Roland Charnay - SNUIPP octobre 2009

Quelles compétences sont nécessaires pour répondre ? (problème 11) 11. Pierre part de l'école à 16 h 35 min. 20 Il va au centre de loisirs puis il rentre chez lui. Quand il arrive à la maison, il regarde l’horloge de la cuisine. Voici ce qu’il voit : Combien de temps s’est-il écoulé depuis que Pierre a quitté l’école ? Lire et comprendre le texte, y prendre la bonne information Lire l’heure, en tenant compte que c’est l’après-midi (contexte) Calculer une durée (de 16 h 35 à 18 h 45) par addition ou par soustraction (peu de place pour gérer les calcul)s Rédiger la réponse sous la forme attendue « Depuis que Pierre a quitté l’école il s’est écoulé deux heures dix minutes » En fonction de quoi peut-on affirmer qu’un élève n’est pas capable de « Résoudre des problèmes concrets faisant intervenir des grandeurs et une ou plusieurs des 4 opérations » ? Roland Charnay - SNUIPP octobre 2009

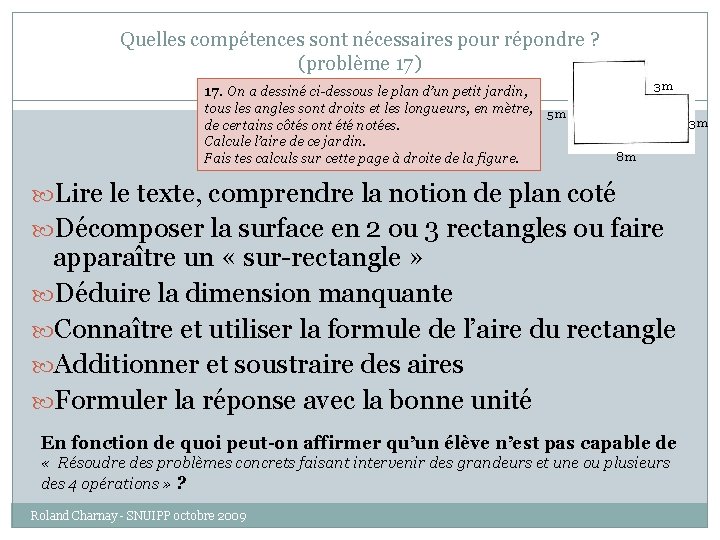

Quelles compétences sont nécessaires pour répondre ? (problème 17) 17. On a dessiné ci-dessous le plan d’un petit jardin, 21 tous les angles sont droits et les longueurs, en mètre, de certains côtés ont été notées. Calcule l’aire de ce jardin. Fais tes calculs sur cette page à droite de la figure. 3 m 5 m 3 m 8 m Lire le texte, comprendre la notion de plan coté Décomposer la surface en 2 ou 3 rectangles ou faire apparaître un « sur-rectangle » Déduire la dimension manquante Connaître et utiliser la formule de l’aire du rectangle Additionner et soustraire des aires Formuler la réponse avec la bonne unité En fonction de quoi peut-on affirmer qu’un élève n’est pas capable de « Résoudre des problèmes concrets faisant intervenir des grandeurs et une ou plusieurs des 4 opérations » ? Roland Charnay - SNUIPP octobre 2009

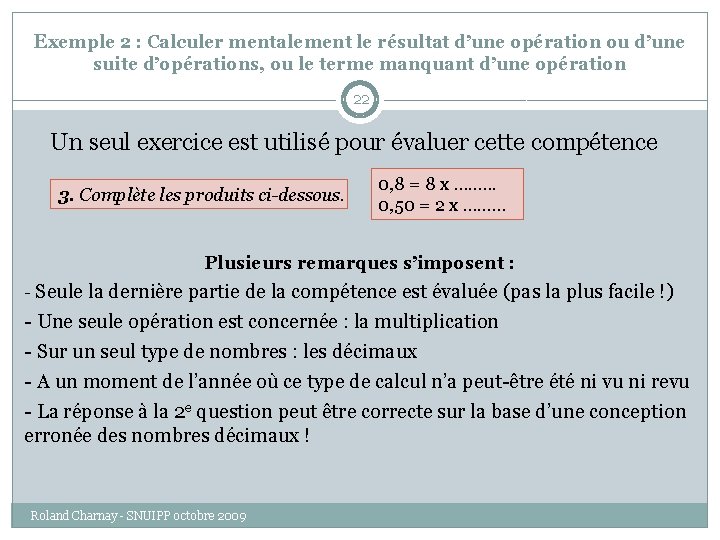

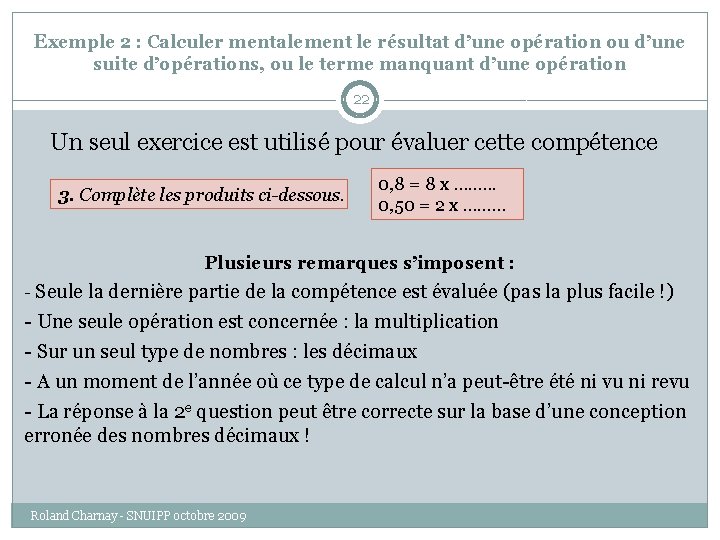

Exemple 2 : Calculer mentalement le résultat d’une opération ou d’une suite d’opérations, ou le terme manquant d’une opération 22 Un seul exercice est utilisé pour évaluer cette compétence 3. Complète les produits ci-dessous. 0, 8 = 8 x ……. . . 0, 50 = 2 x ……… Plusieurs remarques s’imposent : - Seule la dernière partie de la compétence est évaluée (pas la plus facile !) - Une seule opération est concernée : la multiplication - Sur un seul type de nombres : les décimaux - A un moment de l’année où ce type de calcul n’a peut-être été ni vu ni revu - La réponse à la 2 e question peut être correcte sur la base d’une conception erronée des nombres décimaux ! Roland Charnay - SNUIPP octobre 2009

23 En résumé, on n’est pas toujours sûr que la compétence énoncée soit bien celle qui est évaluée dans le problème posé. Dans la classe, cette question se trouve atténuée du fait du nombre de problèmes que l’élève a à résoudre. Dans une évaluation « limitée » le risque de « diagnostic » erroné n’est pas négligeable. Roland Charnay - SNUIPP octobre 2009

24 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

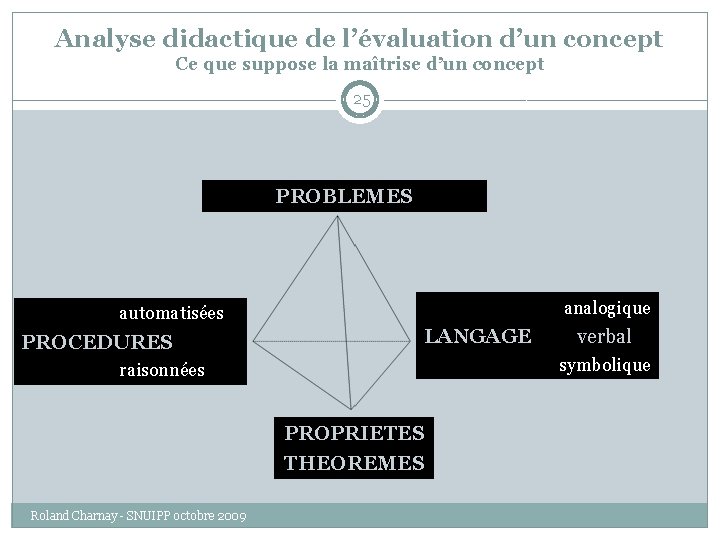

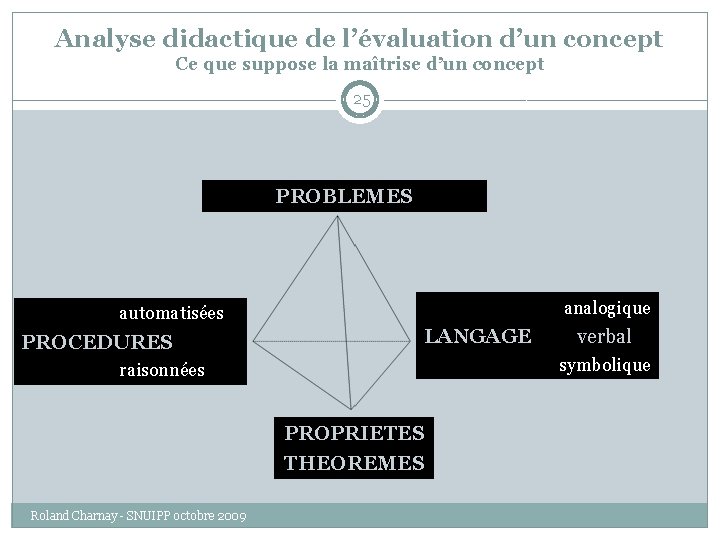

Analyse didactique de l’évaluation d’un concept Ce que suppose la maîtrise d’un concept 25 PROBLEMES analogique automatisées PROCEDURES LANGAGE symbolique raisonnées PROPRIETES THEOREMES Roland Charnay - SNUIPP octobre 2009 verbal

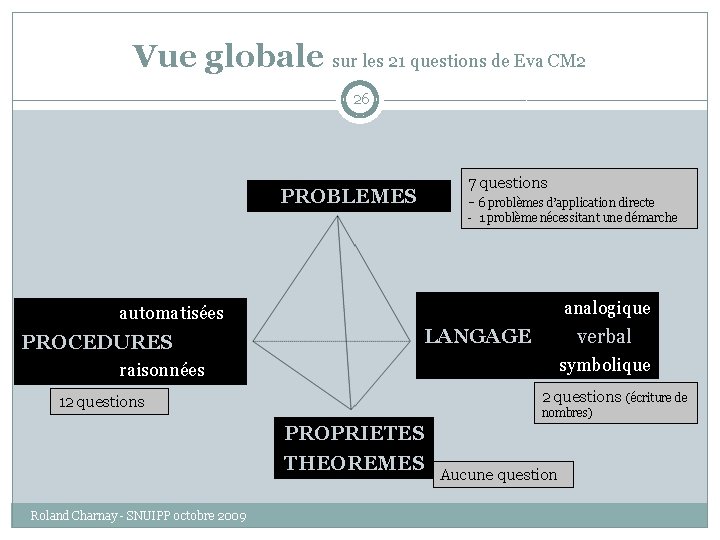

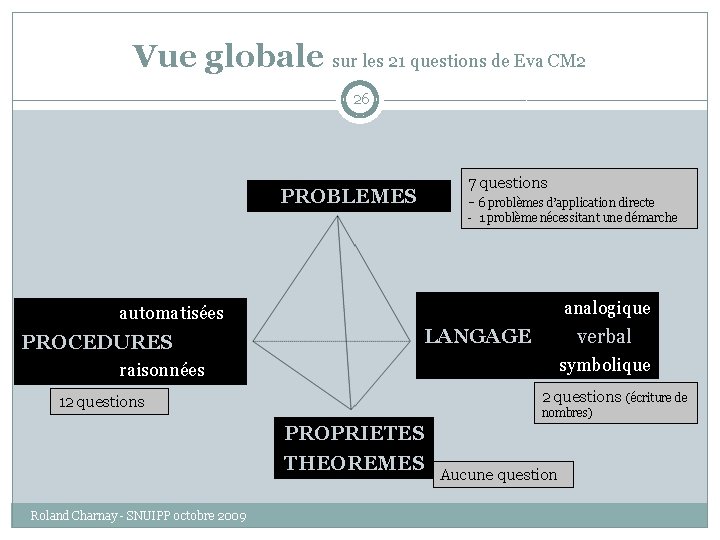

Vue globale sur les 21 questions de Eva CM 2 26 7 questions - 6 problèmes d’application directe PROBLEMES - 1 problème nécessitant une démarche analogique automatisées PROCEDURES LANGAGE verbal symbolique raisonnées 2 questions (écriture de 12 questions nombres) PROPRIETES THEOREMES Roland Charnay - SNUIPP octobre 2009 Aucune question

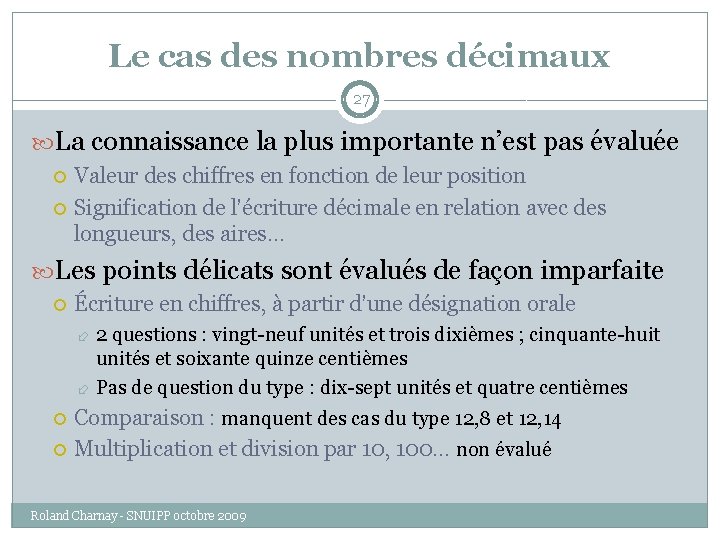

Le cas des nombres décimaux 27 La connaissance la plus importante n’est pas évaluée Valeur des chiffres en fonction de leur position Signification de l’écriture décimale en relation avec des longueurs, des aires… Les points délicats sont évalués de façon imparfaite Écriture en chiffres, à partir d’une désignation orale 2 questions : vingt-neuf unités et trois dixièmes ; cinquante-huit unités et soixante quinze centièmes Pas de question du type : dix-sept unités et quatre centièmes Comparaison : manquent des cas du type 12, 8 et 12, 14 Multiplication et division par 10, 100… non évalué Roland Charnay - SNUIPP octobre 2009

Le cas de la résolution de problèmes 28 Ce que nous apprend PISA Manque d'autonomie des élèves français : "Ils ne s'attaquent qu'aux questions qu'ils pensent pouvoir résoudre, ils ne disposent pas de stratégies pour aborder un problème qui ne leur est pas familier : essayer, expérimenter, bricoler… ne font pas partie des modes d'approche possibles". Antoine Bodin, Les mathématiques face aux évaluations, revue Repères (IREM), octobre 2006 Une évaluation dans laquelle le temps pour répondre est toujours compté ne permet pas d’évaluer le comportement des élèves face à des problèmes dan lesquels il faut « cher pour trouver » et non pas « trouver tout de suite pour répondre » Roland Charnay - SNUIPP octobre 2009

29 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

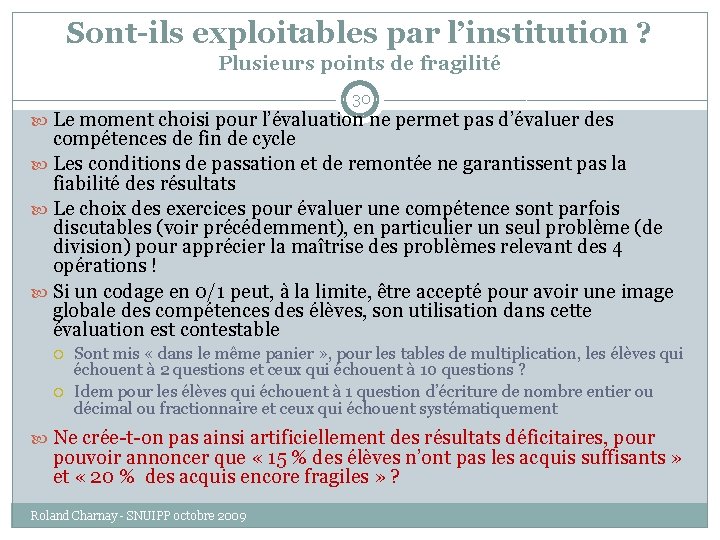

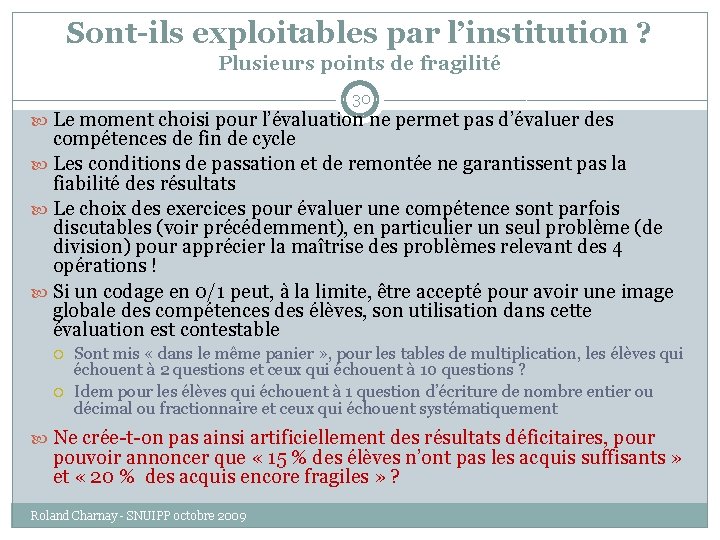

Sont-ils exploitables par l’institution ? Plusieurs points de fragilité 30 Le moment choisi pour l’évaluation ne permet pas d’évaluer des compétences de fin de cycle Les conditions de passation et de remontée ne garantissent pas la fiabilité des résultats Le choix des exercices pour évaluer une compétence sont parfois discutables (voir précédemment), en particulier un seul problème (de division) pour apprécier la maîtrise des problèmes relevant des 4 opérations ! Si un codage en 0/1 peut, à la limite, être accepté pour avoir une image globale des compétences des élèves, son utilisation dans cette évaluation est contestable Sont mis « dans le même panier » , pour les tables de multiplication, les élèves qui échouent à 2 questions et ceux qui échouent à 10 questions ? Idem pour les élèves qui échouent à 1 question d’écriture de nombre entier ou décimal ou fractionnaire et ceux qui échouent systématiquement Ne crée-t-on pas ainsi artificiellement des résultats déficitaires, pour pouvoir annoncer que « 15 % des élèves n’ont pas les acquis suffisants » et « 20 % des acquis encore fragiles » ? Roland Charnay - SNUIPP octobre 2009

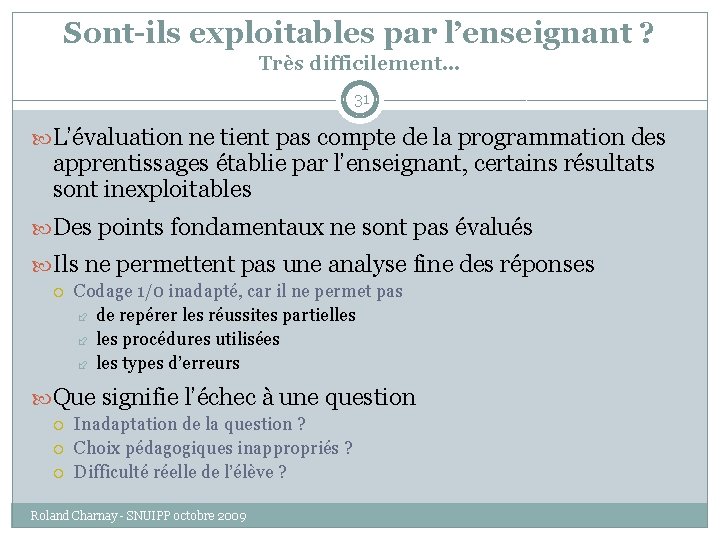

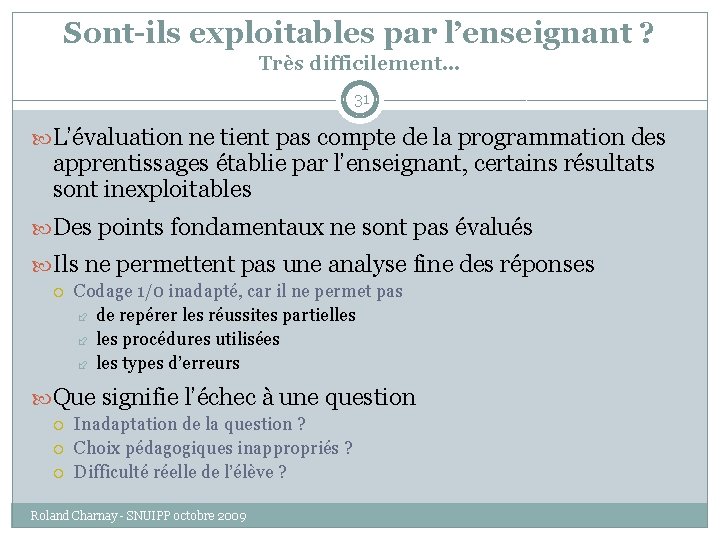

Sont-ils exploitables par l’enseignant ? Très difficilement… 31 L’évaluation ne tient pas compte de la programmation des apprentissages établie par l’enseignant, certains résultats sont inexploitables Des points fondamentaux ne sont pas évalués Ils ne permettent pas une analyse fine des réponses Codage 1/0 inadapté, car il ne permet pas de repérer les réussites partielles procédures utilisées les types d’erreurs Que signifie l’échec à une question Inadaptation de la question ? Choix pédagogiques inappropriés ? Difficulté réelle de l’élève ? Roland Charnay - SNUIPP octobre 2009

L’interprétation des réponses suppose une analyse fine débouchant sur des hypothèses… (exemples analysés par le Directeur de l’enseignement scolaire) 32 Voila un élève qui sait bien faire une addition, mais qui ne maîtrise pas le sens de la virgule ni sa valeur dans un nombre. - Sait-on « faire » une addition quand on ne sait pas la poser ? - Le sens de la virgule est peut-être en cause… mais ce peut être aussi une injonction souvent entendue par l’ élève d’aligner les nombres par la droite et qui n’a pas été encore remise en cause. Roland Charnay - SNUIPP octobre 2009 L’élève a correctement posé l’opération, mais il a fait une erreur de calcul. Il sait manipuler les nombres décimaux, a compris le mécanisme de la soustraction, mais les tables d’addition ne sont pas maîtrisées. - La pose correcte de l’opération peut aussi bien provenir d’une « bonne manipulation des décimaux » que d’une habitude à aligner les nombres par la droite. - On peut, au contraire, faire l’hypothèse qu’il n’a pas compris le mécanisme de la soustraction si on observe la place de la retenue au-dessus et non à gauche de 5 (ce qui le conduit à calculer 16 – 7), auquel cas il connaît ce résultat de la table !

33 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

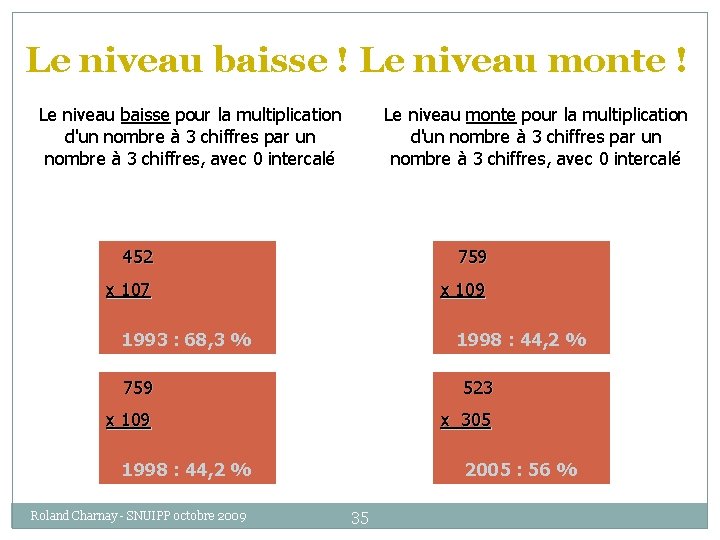

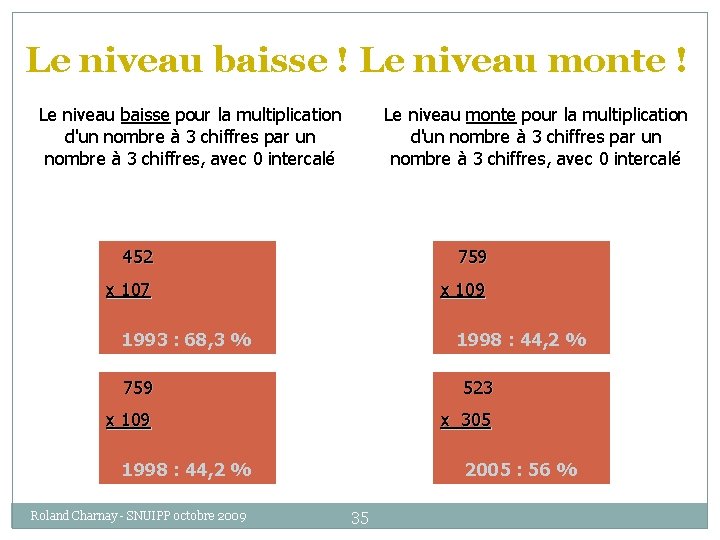

Effets sur « le système » (opinion, politiques, parents…) 34 Si aucune campagne d’explication et d’analyse de cette évaluation n’est conduite, l’école sera « jugée » et « pilotée » sur la base de résultats contestables d’une évaluation contestable. Le risque de manipulation existe Comparaison entre écoles Comparaison dans le temps : elles ne sont possibles que sur la base des mêmes exercices passés dans les mêmes conditions… (cf. exemple page suivante) … sous réserve que le bachotage qui risque de s’installer n’altère pas ces comparaisons Roland Charnay - SNUIPP octobre 2009

Le niveau baisse ! Le niveau monte ! Le niveau baisse pour la multiplication d'un nombre à 3 chiffres par un nombre à 3 chiffres, avec 0 intercalé Le niveau monte pour la multiplication d'un nombre à 3 chiffres par un nombre à 3 chiffres, avec 0 intercalé 452 759 x 107 x 109 1993 : 68, 3 % 1998 : 44, 2 % 759 523 x 109 x 305 1998 : 44, 2 % Roland Charnay - SNUIPP octobre 2009 2005 : 56 % 35

Effets sur les enseignants 36 Risque de réduction du programme aux compétences évaluées chaque année (phénomène des impasses bien connu)… … renforcé par ce qui est dit dans une note de synthèse de l’IGEN (juillet 2009) : Ces évaluations révèlent aussi l’écart, qui peut être important, entre ce qui est enseigné et ce qui devrait l’être. En ce sens les évaluations nationales sont un puissant levier pour une mise en ouvre complète des nouveaux programmes. Impact sur les méthodes d’enseignement : entraînement aux tests, centration sur les réponses plutôt que sur les procédures (cf. système de codage) Impression (ou réalité !) d’être contrôlés à travers ces tests pression accrue sur les enseignants Remise en cause de la professionnalité et de la liberté pédagogique des enseignants, notamment : Sur leur responsabilité de programmer leur enseignement en fonction de leurs élèves Sur leur responsabilité de mettre en place des modalités d’évaluation Roland Charnay - SNUIPP octobre 2009

Effets sur les élèves 37 Accroissement des phénomènes de stress et d’angoisse déjà très présents chez les élèves français (cf. PISA) Je suis très tendu(e) quand j’ai un devoir de mathématiques à faire Je deviens très nerveux (se) quand je travaille à des problèmes de mathématiques France Finlande Pays Bas 53 39 7 15 7 16 « Apprendre pour savoir » ou « apprendre pour bien répondre » Roland Charnay - SNUIPP octobre 2009

38 Les finalités de cette évaluation sont-elles claires ? L’évaluation est-elle bien conçue ? Evalue-t-on ce qui est important ? Les résultats sont-ils exploitables ? Quels peuvent-être les effets de cette évaluation ? Quelles leçons peut-on tirer d’expériences à l’étranger ? Roland Charnay - SNUIPP octobre 2009

Remise en cause en Angleterre (cf. Café pédagogique du 22/09/2008 39 Le pilotage par l'évaluation nuit à l'enseignement des maths affirme un rapport officiel britannique Les rapporteurs de l'Ofsted, l'organe d'inspection britannique, n'ont pas été dupes. S'ils relèvent qu'aux tests officiels, le niveau n'en finit pas de monter, en réalité peu d'élèves sont bons en maths, et ce sont plutôt des garçons. Les inspecteurs de l'Ofsted mettent directement en cause les tests d'évaluation qui sont utilisés en Angleterre pour évaluer les établissements et piloter le système éducatif. "A l'évidence des stratégies pour améliorer les résultats aux tests, y compris des leçons spéciales, des classes de révision, l'accent mis sur l'entraînement aux tests, réussissent à préparer les élèves à réussir les tests mais ne les équipe pas bien en compétences mathématiques pour le futur". Pour l'Ofsted les élèves ne comprennent pas les maths, ont peu confiance en eux, ne trouvent pas de sens dans ce qu'ils font. L'Ofsted recommande de changer les tests en mettant des exercices de compréhension. Cette étude vient après une série de travaux qui tous aboutissent à remettre en question le pilotage par l'évaluation. Roland Charnay - SNUIPP octobre 2009

Les études existent… 40 Voir le rapport de Nathalie Mons publié en août 2009 sur « Les effets théoriques et réels de l’évaluation standardisée » pour Eurydice (recherches européennes sur l’enseignement) Voir aussi son interview sur le Café pédagogique du 18 septembre 2009 Il faut avancer avec circonspection dans le domaine des politiques d’évaluation standardisée. L’outil peut tout à fait avoir sa place dans un système éducatif mais les effets pervers que l’on peut voir se développer dans certains contextes nationaux invitent à la prudence. Roland Charnay - SNUIPP octobre 2009

Pour conclure… Il s’agit avant tout de proposer aux maîtres un outil qui leur manquait pour leur propre pilotage pédagogique : un instrument commun de mesure (si j’osais, je dirais un thermomètre commun) référé à une unité commune de mesure : le programme, avec ses progressions. Discours du Directeur de l’enseignement scolaire Beaucoup de questions se posent autour de la fabrication du thermomètre… Autant de concepteurs… autant de températures ! En réalité, il n’existe pas d’évaluation objective. Roland Charnay - SNUIPP octobre 2009 41

D’autres images… Evaluation - éclairage ? Evaluation – caméra de surveillance? Roland Charnay - SNUIPP octobre 2009 42 Evaluation – radar ?

La preuve torrent

La preuve torrent Décrivez votre parcours professionnel

Décrivez votre parcours professionnel Apres quelques temps tu apprendras

Apres quelques temps tu apprendras Fixed income valuation methods

Fixed income valuation methods Comment articuler mieux

Comment articuler mieux Coop pour toi et pour moi

Coop pour toi et pour moi Barchan dune definition

Barchan dune definition Coastal deposition diagram

Coastal deposition diagram Dune software

Dune software Tessa oliver

Tessa oliver Patron dune pyramide

Patron dune pyramide Salusa secundus

Salusa secundus Sand dunes definition

Sand dunes definition Edinburgh university ppe

Edinburgh university ppe Dune rpg

Dune rpg In the desert, ephemeral streams _____.

In the desert, ephemeral streams _____. Ameen rihani

Ameen rihani Climax

Climax Dune firmware

Dune firmware La dune clib

La dune clib Dune sp

Dune sp Plan dune

Plan dune Hyperstatisme

Hyperstatisme Sundial on parnidis dune, curonian spit, lithuania

Sundial on parnidis dune, curonian spit, lithuania Kirk t. mcdonald

Kirk t. mcdonald Plan de dissertation juridique

Plan de dissertation juridique Software development t shirt sizing

Software development t shirt sizing Calculate price of bond

Calculate price of bond Gas station valuation

Gas station valuation Cdo valuation

Cdo valuation Avco stock valuation

Avco stock valuation Valuation and capital budgeting for the levered firm

Valuation and capital budgeting for the levered firm Chapter 6 interest rates and bond valuation

Chapter 6 interest rates and bond valuation Fx option pricing

Fx option pricing Fuze valuation

Fuze valuation Mvs valuation

Mvs valuation Pvgo example

Pvgo example Cross holding valuation

Cross holding valuation Swaption valuation

Swaption valuation Valuing intangible assets

Valuing intangible assets Floating rate note pricing

Floating rate note pricing Valuation of farm assets

Valuation of farm assets Vertical scope stock

Vertical scope stock