14 1 Spark R Spark R l Spark

- Slides: 29

14. 1 认识Spark. R 第十四章 Spark. R l 安装Spark. R 此安装步骤是Spark跑在Hadoop Yarn架构上的安装方式,如 果是跑在独立的Spark环境上,请参照Spark. R官网 (https: //github. com/amplab-extras/ Spark. R-pkg)。 (1)安装依赖包: install. packages("r. Java") yum install libcurl-devel install. packages("RCurl") install. packages("devtools") 服务器需要安装maven服务(参照: http: //blog. csdn. net/zdnlp/article/details/7457596。

14. 1 认识Spark. R 第十四章 Spark. R l 安装Spark. R (2)安装Spark. R包 library(devtools) install_github("amplab-extras/Spark. Rpkg", subdir="pkg") USE_YARN=1 SPARK_YARN_VERSION=2. 4. 0 SPARK_HAD OOP_VERSION=2. 4. 0 USE_MAVEN=1. /install-dev. sh (3)Linux下加载R包 install. packages('Cairo', dependencies=TRUE, repos='http: //cran. rstudio. com/')

14. 1 认识Spark. R 第十四章 Spark. R l 在R或Rstudio中调用Spark. R library(Spark. R) sc<-spark. R. init(master="local", "Rword. Count") lines<- text. File(sc, "hdfs: //XXXIP): 8020/test/log. txt") words <-flat. Map(lines, function(line) {strsplit(line, ", ")[[1]]} ) count(words)

14. 2 Spark. Data. Frame 第十四章 Spark. R的核心是Spark. Data. Frames,是一个基于Spark的分布式数 据框架。在概念上和关系型数据库中的表类似,或者和R语言中的数据框 类似。 Spark. Data. Frame可以完成以下操作: (1)数据缓存控制:cache(), persist(), unpersist(); (2)数据保存:save. As. Text. File(),save. As. Object. File(); (3)常用的数据转换操作: 如map(), flat. Map(), map. Partitions()等; (4)数据分组、聚合操作: 如 partition. By(), group. By. Key(), reduce. By. Key()等; (5)join操作: 如join(), full. Outer. Join(), left. Outer. Join()等; (6)排序操作, 如sort. By(), sort. By. Key(), top()等; (7)Zip操作,如zip(), zip. With. Index(), zip. With. Unique. Id(); (8)重分区操作,如coalesce(), repartition()。

14. 3 综合练习 第十四章 Spark. R l 加载数据 创建数据框的最简单的方法是将一个本地R数据框转换为一个Spark数 据框。可以使用as. Data. Frame或者create. Data. Frame以及通过在本地 的R数据框来创建一个Spark. Data. Frames。例如。以下用R的数据集创 建一个Spark. Data. Frames。 >df <- as. Data. Frame(faithful) ># Displays the first part of the Spark. Data. Frame >head(df)

14. 3 综合练习 第十四章 Spark. R l Spark. Data. Frame基本操作 (1)选择行和列 ># Create the Spark. Data. Frame >df <- as. Data. Frame(faithful) ># Get basic information about the Spark. Data. Frame >df >head(select(df, "eruptions")) >head(filter(df, df$waiting < 50))

14. 3 综合练习 第十四章 Spark. R l Spark. Data. Frame基本操作 (2)分组,聚合 Spark. R数据框致辞一些常用功能将分组后的数据聚合。例如,可以计算 数据集的等待时间直方图,如下所示。 # We use the `n` operator to count the number of times each waiting time appears >head(summarize(group. By(df, df$waiting), count = n(df$waiting)))

14. 3 综合练习 第十四章 Spark. R l Spark. Data. Frame基本操作 (3)在列上操作 Spark. R还提供了一些功能,可以直接应用于列的数据处理和聚合。下面的 列子显示了基本的算术函数的使用。 # Convert waiting time from hours to seconds. # Note that we can assign this to a new column in the same Spark. Data. Frame >df$waiting_secs <- df$waiting * 60 >head(df)

14. 3 综合练习 第十四章 Spark. R l Spark. Data. Frame基本操作 (4)应用用户定义函数 在Spark. R中,支持用户定义函数: 在大型数据集上使用dapply或dapply. Collect。 ①dapply。 应用到Spark. Data Frames的每一个分区。 # Convert waiting time from hours to seconds. # Note that we can apply UDF to Data. Frame. >schema <- struct. Type(struct. Field("eruptions", "double"), struct. Field("waiting_secs", "double")) >df 1 <- dapply(df, function(x) { x <- cbind(x, x$waiting * 60) }, schema) >head(collect(df 1)

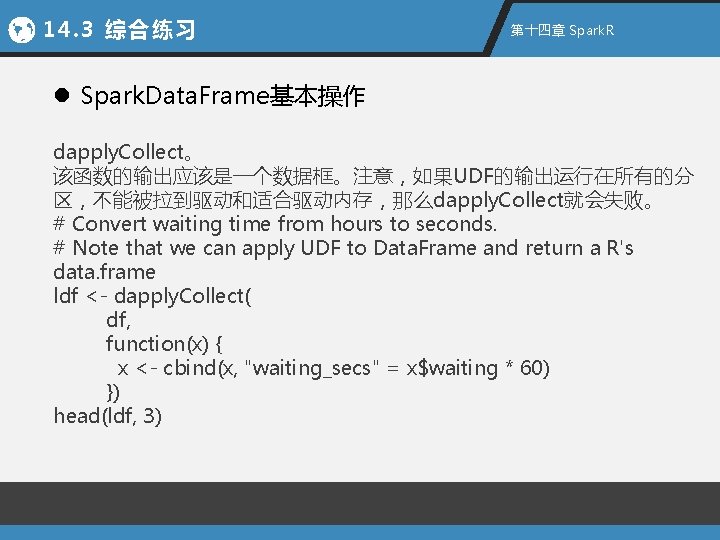

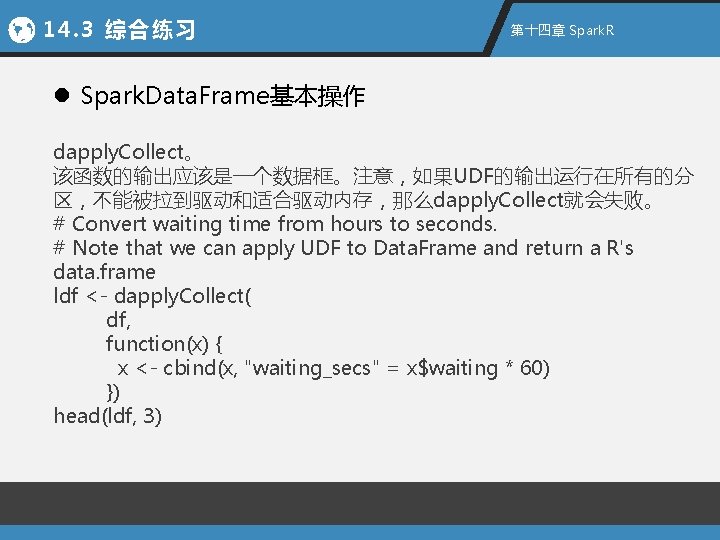

14. 3 综合练习 第十四章 Spark. R l Spark. Data. Frame基本操作 dapply. Collect。 该函数的输出应该是一个数据框。注意,如果UDF的输出运行在所有的分 区,不能被拉到驱动和适合驱动内存,那么dapply. Collect就会失败。 # Convert waiting time from hours to seconds. # Note that we can apply UDF to Data. Frame and return a R's data. frame ldf <- dapply. Collect( df, function(x) { x <- cbind(x, "waiting_secs" = x$waiting * 60) }) head(ldf, 3)

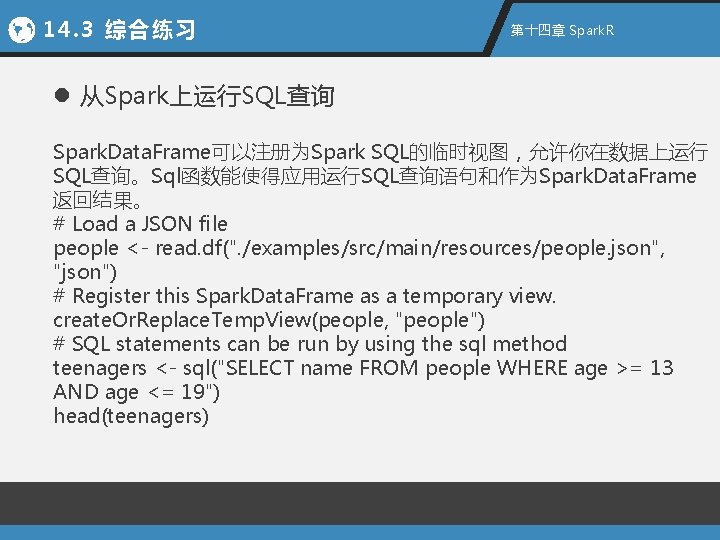

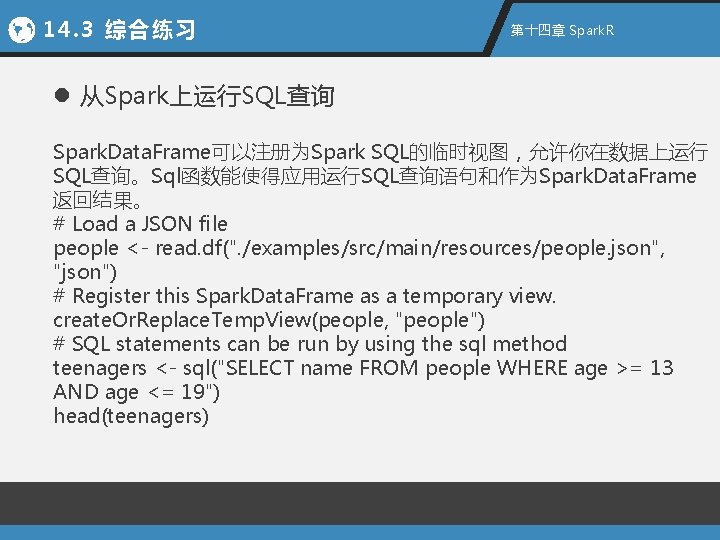

14. 3 综合练习 第十四章 Spark. R l 从Spark上运行SQL查询 Spark. Data. Frame可以注册为Spark SQL的临时视图,允许你在数据上运行 SQL查询。Sql函数能使得应用运行SQL查询语句和作为Spark. Data. Frame 返回结果。 # Load a JSON file people <- read. df(". /examples/src/main/resources/people. json", "json") # Register this Spark. Data. Frame as a temporary view. create. Or. Replace. Temp. View(people, "people") # SQL statements can be run by using the sql method teenagers <- sql("SELECT name FROM people WHERE age >= 13 AND age <= 19") head(teenagers)

14. 3 综合练习 第十四章 Spark. R l spark. R操作hdfs上的文件 ①上传文件,并查看 hdfs. init() hdfs. put("/opt/bin/jar/people. json", "hdfs: //nameservice 1/tmp/resour ces/people 2. json") hdfs. cat("hdfs: //nameservice 1/tmp/resources/people. json")

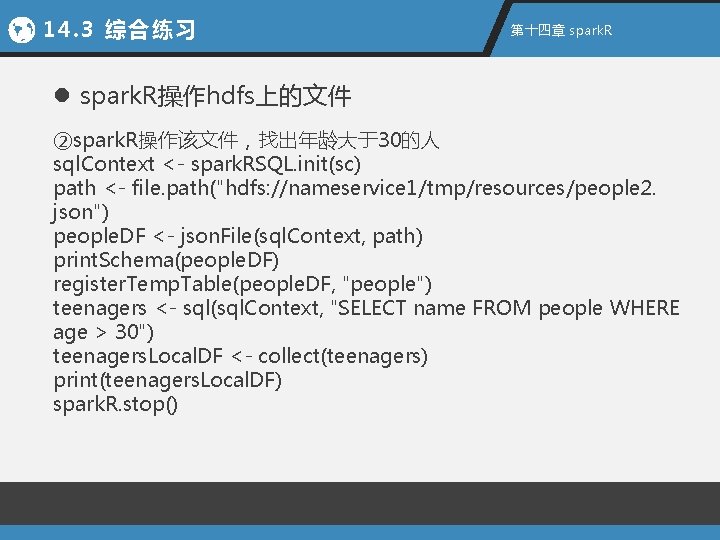

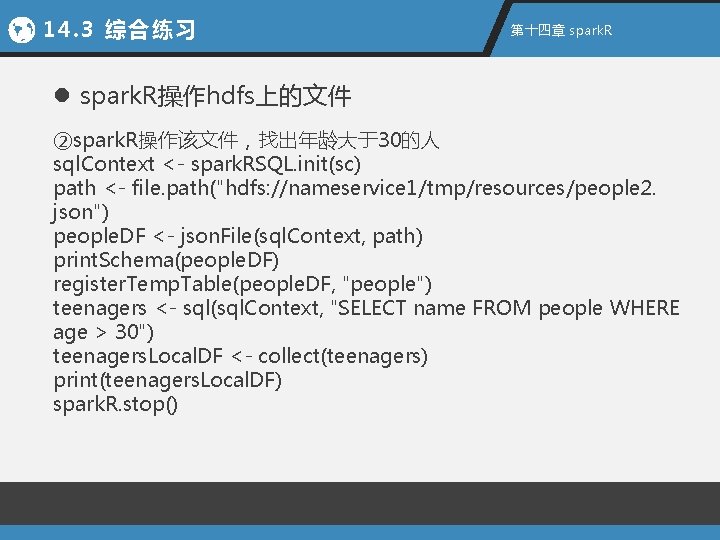

14. 3 综合练习 第十四章 spark. R l spark. R操作hdfs上的文件 ②spark. R操作该文件,找出年龄大于30的人 sql. Context <- spark. RSQL. init(sc) path <- file. path("hdfs: //nameservice 1/tmp/resources/people 2. json") people. DF <- json. File(sql. Context, path) print. Schema(people. DF) register. Temp. Table(people. DF, "people") teenagers <- sql(sql. Context, "SELECT name FROM people WHERE age > 30") teenagers. Local. DF <- collect(teenagers) print(teenagers. Local. DF) spark. R. stop()

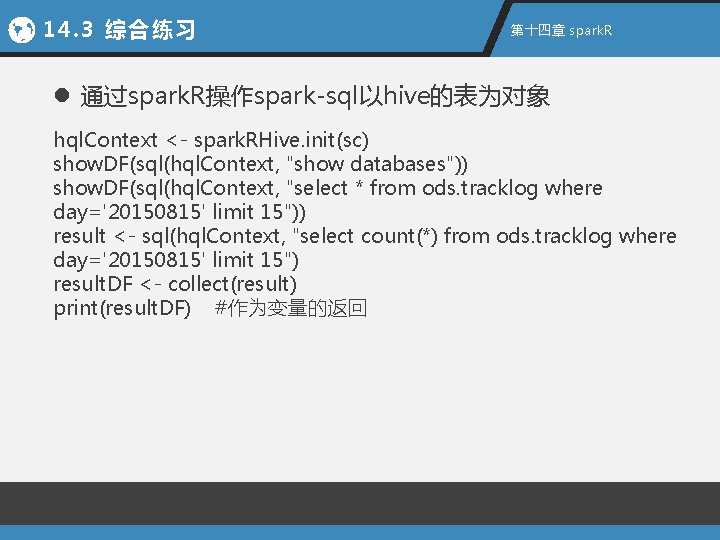

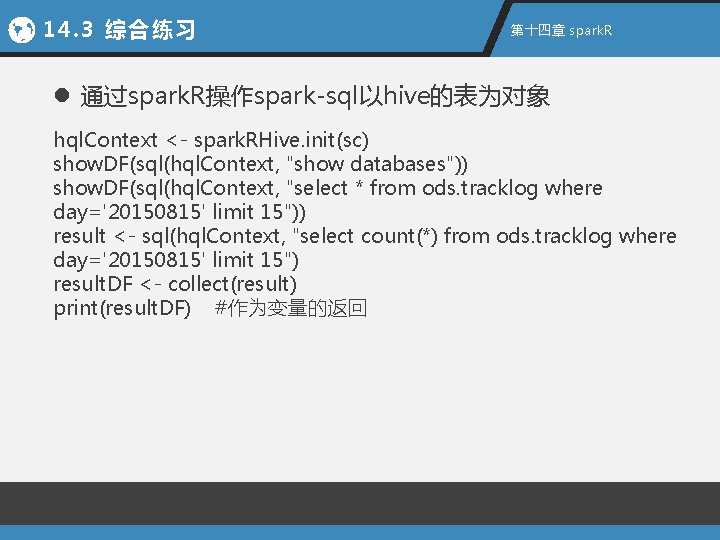

14. 3 综合练习 第十四章 spark. R l 通过spark. R操作spark-sql以hive的表为对象 hql. Context <- spark. RHive. init(sc) show. DF(sql(hql. Context, "show databases")) show. DF(sql(hql. Context, "select * from ods. tracklog where day='20150815' limit 15")) result <- sql(hql. Context, "select count(*) from ods. tracklog where day='20150815' limit 15") result. DF <- collect(result) print(result. DF) #作为变量的返回

Spark sql: relational data processing in spark

Spark sql: relational data processing in spark Zeppelin ldap

Zeppelin ldap What is tensor in machine learning

What is tensor in machine learning Apache spark concepts

Apache spark concepts Electrospark deposition

Electrospark deposition Introduction to apache spark

Introduction to apache spark Spark: cluster computing with working sets

Spark: cluster computing with working sets Spark payroll and administrative sanction

Spark payroll and administrative sanction Gainsight cockpit

Gainsight cockpit Driver program spark

Driver program spark The spark that ignited ww1

The spark that ignited ww1 David ripplinger

David ripplinger Adobe spark api

Adobe spark api Spark 2 module 5

Spark 2 module 5 Spark uc berkeley

Spark uc berkeley Spark plasma sintering

Spark plasma sintering Huck finn ch 24 summary

Huck finn ch 24 summary Matei zaharia

Matei zaharia Apache spark twitter

Apache spark twitter Cache spark

Cache spark Harvard mentor manage

Harvard mentor manage Adobe spark accessibility

Adobe spark accessibility Spark test steel

Spark test steel Spark runtime architecture

Spark runtime architecture Sip gruu

Sip gruu Cisco doc exchange

Cisco doc exchange Spark 20

Spark 20 Spark tutorial

Spark tutorial Driver program spark

Driver program spark Apache spark challenges

Apache spark challenges